新门内部资料精准大全:详细步骤指南

欢迎来到“新门内部资料精准大全”!本指南将帮助你完成某项任务或学习某种技能。无论你是初学者还是进阶用户,都能在这里找到清晰、易懂的步骤和示例。让我们开始吧!

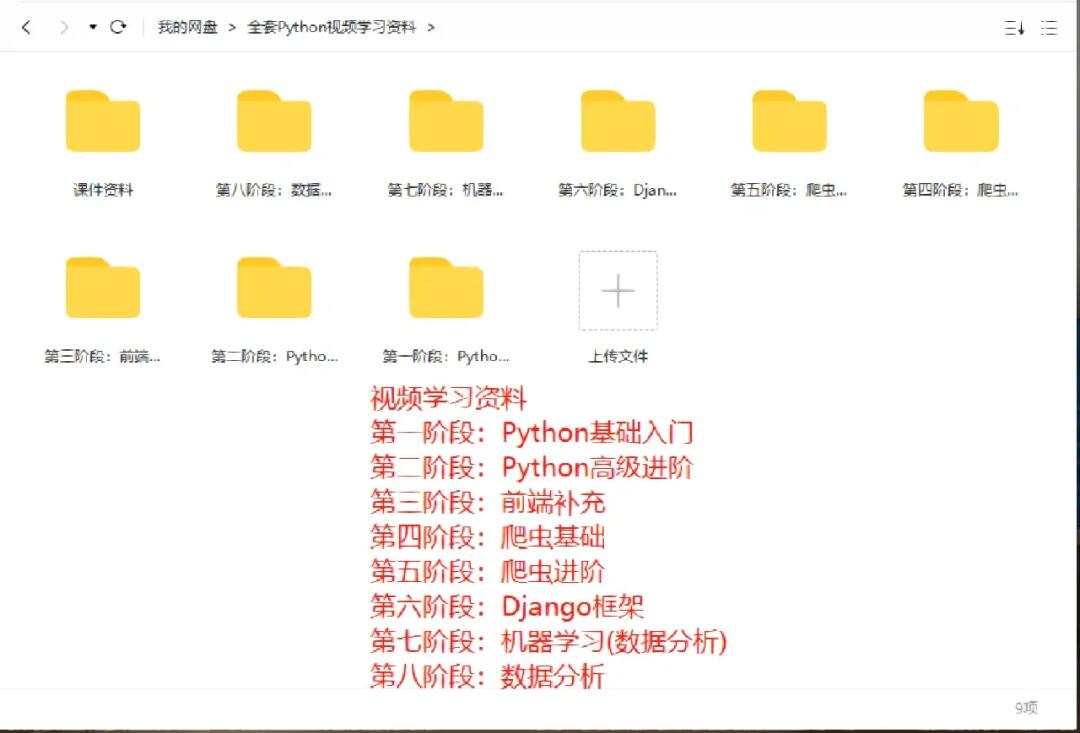

任务/技能概述

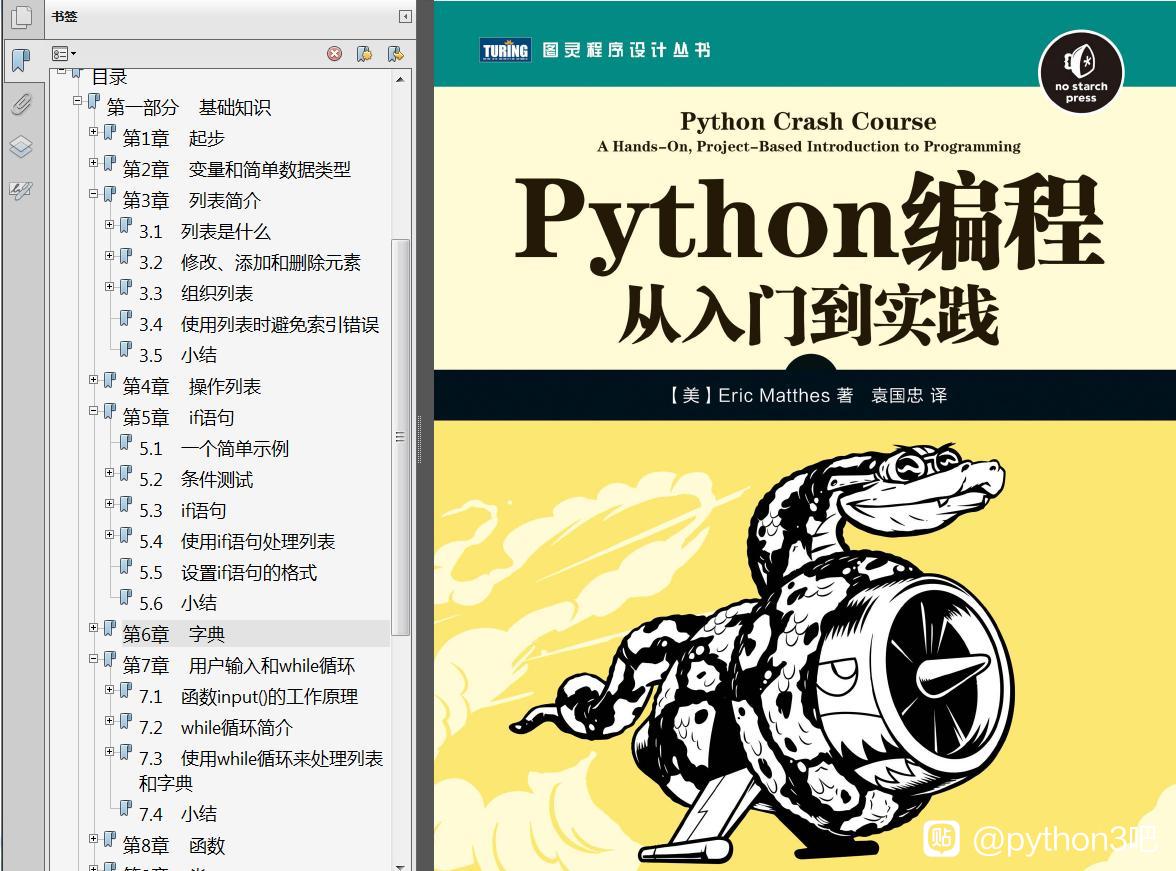

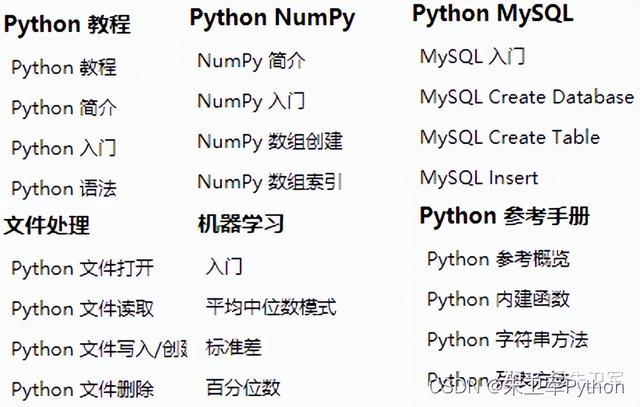

在开始之前,我们先简要了解一下你要完成的任务或学习的技能。假设我们要学习如何使用Python编写一个简单的Web爬虫。

步骤1:环境准备

解释

首先,你需要确保你的计算机上安装了Python和必要的库。

示例

- 安装Python:访问Python官网下载并安装最新版本的Python。

- 安装必要的库:打开命令行工具,输入以下命令安装

requests和beautifulsoup4库:pip install requests beautifulsoup4

步骤2:编写基本代码

解释

接下来,我们将编写一个简单的Python脚本来发送HTTP请求并解析网页内容。

示例

- 创建Python文件:在你的工作目录下创建一个名为

web_crawler.py的文件。 - 编写代码:

import requests

from bs4 import BeautifulSoup

# 发送HTTP请求

url = "https://example.com"

response = requests.get(url)

# 解析网页内容

soup = BeautifulSoup(response.text, 'html.parser')

print(soup.title.string)

步骤3:运行代码

解释

现在,你可以运行你的Python脚本来查看结果。

示例

- 运行脚本:在命令行工具中导航到你的工作目录,然后输入以下命令:

python web_crawler.py

- 查看输出:你应该会看到网页的标题被打印出来。

步骤4:进阶功能

解释

如果你是进阶用户,可以尝试添加更多功能,比如提取特定元素或处理异常。

示例

- 提取特定元素:

for link in soup.find_all('a'):

print(link.get('href'))

- 处理异常:

try:

response = requests.get(url)

response.raise_for_status()

except requests.exceptions.HTTPError as err:

print(f"HTTP error occurred: {err}")

总结

通过以上步骤,你已经学会了如何使用Python编写一个简单的Web爬虫。无论你是初学者还是进阶用户,都可以根据需要扩展和优化这个脚本。希望这篇指南对你有所帮助!

如果你有任何问题或需要进一步的帮助,请随时查阅“新门内部资料精准大全”中的其他资源。祝你学习愉快!

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号